این راهنما روشهای عملی و گامبهگام برای مانیتورینگ uptime API را ارائه میدهد. هدف این است تا پایداری سرویسها را افزایش داده و زمان قطع سرویس را کاهش دهید. این مطالب برای کارشناسان زیرساخت، تیمهای دوآپس، مهندسان شبکه، مدیران دیتاسنتر و توسعهدهندگان backend مناسب است که مسئول تضمین دسترسپذیری APIها هستند.

در این بخش مقدماتی، فرآیند مانیتورینگ به طور کلی توضیح داده میشود. همچنین، مروری بر مفاهیم پایه مانند مانیتور کردن Uptime API، پایش دسترسپذیری API و مانیتورینگ API Endpoint انجام میشود. هدف شما پس از مطالعه این مقاله، طراحی و پیادهسازی استراتژیهای چک سلامت، اعلان، لاگ و خودکارسازی است.

متن با تمرکز بر کاربردی بودن نوشته شده است. هدف این است تا بتوانید سریع تصمیمهای فنی بگیرید. ابزارها یا سرویسهایی مانند Kubernetes as a Service یا Uptimus as a Service از ارائهدهندگان معتبر را در مراحل بعدی برای بهبود روند مانیتورینگ در نظر بگیرید.

نکات کلیدی

- هدف اصلی: افزایش پایداری و کاهش زمان قطع سرویس از طریق مانیتور کردن Uptime API.

- مخاطب: تیمهای زیرساخت، دوآپس، شبکه و توسعهدهندگان backend.

- نتیجه: توانایی طراحی چک سلامت، اعلان و خودکارسازی برای APIها.

- تمرکز سئویی: استفاده طبیعی از monitor api endpoint uptime و عبارات مرتبط.

- همافزایی: امکان ادغام با سرویسهای ابری و مدیریت شده مثل Kubernetes as a Service برای بهبود پایش دسترسپذیری API.

مقدمهای بر اهمیت مانیتورینگ Uptime برای API Endpoint

APIها، قلب تبادل داده بین سرویسهای داخلی و محصولات مشتری هستند. پایش مداوم برای حفظ دسترسپذیری ضروری است. اهمیت Uptime در این زمینه، تضمین ارائهی سرویس و جلوگیری از تأثیر Downtime بر جریان کاری شما است.

یک API خراب میتواند به سرعت سرویسهای وابسته را از کار بیندازد. این امر تجربه کاربری API را تضعیف میکند. افت کیفیت پاسخ یا خطاهای پیدرپی باعث نارضایتی کاربر نهایی میشود و نرخ ریزش را بالا میبرد.

از منظر کسبوکار، کاهش Uptime مترادف است با از دست رفتن درآمد و افزایش هزینههای پشتیبانی. رعایت SLA برای API بخش مهمی از مدیریت ریسک مالی و تعهد به مشتریان شماست.

این مقاله برای کارشناسان زیرساخت، شبکه، تیمهای دوآپس و مدیران دیتاسنتر نوشته شده است. هدف ارائهی چارچوبی عملی برای طراحی، پیادهسازی و بهینهسازی مانیتورینگ است. این کار سطح دسترسپذیری را بهبود میبخشد.

برای پیادهسازی توصیهها میتوانید از خدمات زیرساختی مانند Infrastructure as a Service و Kubernetes as a Service استفاده کنید. این کار پایداری را افزایش میدهد و بار ناشی از تأخیر و تأثیر Downtime را کاهش میدهد.

| وجه | اثر بر عملیات | نمونهٔ اقدام فوری |

|---|---|---|

| عملکرد کاربر | کاهش نرخ نگهداری، نارضایتی کاربران | افزایش تعداد چکها و رصد تجربه کاربری API |

| مالی | کاهش درآمد، هزینههای پشتیبانی افزایش | تعریف و پیگیری SLA برای API و جبراندهی |

| فنی | زنجیرهای از خطاها در سرویسهای وابسته | پیادهسازی چکهای سلامت و مانیتورینگ توزیعشده |

| ریسک مدیریتی | کاهش اعتماد مشتری و اعتبار برند | گزارشدهی شفاف و پلن بازیابی سرویس |

تعاریف پایه: Uptime، SLA و SLO در مانیتورینگ API

در این بخش به تعاریف کلیدی میپردازیم تا مبنای مانیتورینگ مشخص شود. فهم درست این مفاهیم، آستانههای هشدار و گزارشدهی را منطقی طراحی میکند.

تعریف Uptime درصد زمانی است که سرویس در دسترس و عملکردی است. Downtime دورههایی را شامل میشود که سرویس در دسترس نیست یا کارکرد مورد انتظار را ارائه نمیدهد.

Uptime را معمولاً به صورت درصد گزارش میکنند. برای مثال 99.9% Uptime به معنی حداکثر حدود 8.76 ساعت downtime در سال است. داشتن تعریف Uptime واضح، پایهای برای تعیین SLA و SLO است.

SLA و SLO دو سطح تعریف هدف را در بر میگیرند. SLA (Service Level Agreement) توافق رسمی بین ارائهدهنده و مشتری درباره سطح خدمات است. نقض SLA میتواند پیامدهای قراردادی داشته باشد و رضایت مشتری را کاهش دهد.

SLO (Service Level Objective) اهداف عملیاتی داخلی هستند که برای برآورده کردن SLA طراحی میشوند. شما با تعیین SLO مشخص، میتوانید اهدافی مانند 99.9% Uptime یا حداکثر Latency را کمّی کنید.

وقتی SLA و SLO بهدرستی تعریف شده باشند، تنظیم آستانههای هشدار و اولویتبندی واکنش تیم سادهتر میشود. این یک پیشنهاد عملی برای تنظیم معیارهای مانیتورینگ است.

برای سنجش وضعیت فنی API از KPIهای API استفاده میکنید. این شاخصها معیارهای قابل اندازهگیری برای پایش سلامت سرویس هستند.

مهمترین معیارهای دسترسپذیری عبارتاند از:

- Uptime درصد

- نرخ خطا (Error Rate) شامل خطاهای HTTP 4xx و 5xx

- میانگین زمان پاسخ (Avg Latency)

- P95 و P99 latency برای نمایش بالاترین تاخیرها

- تعداد رخدادهای قطع و میانگین زمان رفع (MTTR)

در جدول زیر یک نمای خلاصه از هر شاخص و کاربرد عملی آن را میبینید تا بتوانید معیارهای دسترسپذیری را بهتر پیادهسازی کنید.

| شاخص | تعریف | چرا مهم است | مثال هدف (SLO) |

|---|---|---|---|

| Uptime درصد | نسبت زمان در دسترس بودن سرویس به کل زمان | نمایانگر کلی پایداری سرویس | 99.9% در ماه |

| نرخ خطا | نسبت درخواستهای با خطا (4xx/5xx) به کل درخواستها | نشاندهنده کیفیت پاسخدهی و مشکلات عملکردی | <0.5% خطا |

| میانگین زمان پاسخ | میانگین تاخیر پاسخ به درخواستها | تجربه کاربر را مستقیماً تحت تاثیر قرار میدهد | <300ms |

| P95 / P99 | تاخیر در صدکهای بالا برای شناسایی پیکهای تأخیر | پیشبینی نقاط بحرانی و آمادهسازی مقیاسبندی | P95 <500ms, P99 <1s |

| MTTR | میانگین زمان رفع وقفهها | توانایی بازیابی سرویس را اندازهگیری میکند | <30min |

جمعبندی کاربردی: با تعیین روشنِ SLA و SLO و پیادهسازی KPIهای API مناسب، میتوانید معیارهای دسترسپذیری را به عنوان مبنایی برای هشداردهی و گزارشدهی استفاده کنید. این کار به شما کمک میکند تا واکنش تیم و ابزارها را منطبق بر نیازهای تجاری تنظیم کنید.

پیشنیازهای فنی برای مانیتورینگ API Endpoint

راهاندازی موفقیتآمیز مانیتورینگ API نیازمند آمادهسازی پیشنیازهای شبکهای، مجوزها و ابزارهای لازم است. در این بخش، گامهای عملی برای تأمین دسترسی پایدار و امن به Endpointها ارائه میشود.

نیازمندیهای شبکه و دسترسی

دسترسی پایدار از نقاط مانیتورینگ به Endpointها از اهمیت بالایی برخوردار است. پیکربندی صحیح آدرسهای DNS برای جلوگیری از تکرار خطاهای نامبرداری ضروری است.

بررسی دقیق روتینگ و قواعد فایروال برای مجاز شمردن ترافیک مانیتورینگ الزامی است. در محیطهای محافظتشده، سفیدسازی IPهای ثابت میتواند مفید باشد.

مجوزها و احراز هویت در تستها

مدیریت امن توکنها و کلیدهای API برای چکهای مداوم اهمیت دارد. استفاده از حسابهای با سطح دسترسی محدود برای تستها میتواند خطر دسترسی غیرمجاز را کاهش دهد.

استانداردهای OAuth و OpenID برای فرآیند احراز هویت API باید رعایت شوند. اطلاعات حساس باید در لاگهای عمومی ثبت نشود.

ابزارها و کتابخانههای مورد نیاز

برای تستهای ساده، از curl یا ابزارهای مانند axios و requests استفاده کنید. این ابزارها برای تست دستی و اسکریپتنویسی مناسب هستند.

برای جمعآوری متریک و داشبوردینگ، Prometheus و Grafana گزینههای شناختهشدهاند. برای ترِیسینگ، Jaeger یا Zipkin را به جریان لاگ و ترِیس متصل کنید.

ابزارهای تست خودکار مانند Postman و Newman به شما کمک میکنند تا سناریوهای عملکردی را اجرا کنید. برای لاگینگ ساختاریافته، Serilog یا Logback را استفاده کنید.

نکته عملی: اگر از سرویسهای Firewall as a Service یا Balancer as a Service استفاده میکنید، تنظیمات اجازه دسترسی و health-check را با تنظیمات مانیتورینگ همسو کنید تا چکها با خطا مواجه نشوند.

معرفی روشهای مختلف برای بررسی Uptime

برای اندازهگیری در دسترس بودن API، چندین رویکرد مختلف وجود دارد. هر یک دارای نقاط قوت و ضعف خاصی هستند. ترکیب مناسب این روشها، دقت بیشتر و کاهش هشدارهای کاذب را تضمین میکند.

اولین روش، پینگ ساده با استفاده از ICMP است. این روش سریع و ارزان است و نشان میدهد که میزبان شبکه پاسخ میدهد.

با این حال، پینگ ساده محدودیتهایی دارد. ممکن است سرور بالا باشد اما سرویس API داخلی دچار مشکل باشد. بنابراین، پینگ تنها برای بررسی در دسترس بودن کافی نیست.

چکهای سطح اپلیکیشن با HTTP(S) امکان فراخوانی مسیرهای مشخص و بررسی کدهای وضعیت مانند 200 یا 204 را فراهم میآورد. این چکها به شما اجازه میدهند محتوای پاسخ را نیز بررسی کنید تا خطاهای منطقی شناسایی شوند.

HTTP health check خطاهای منطقی و پاسخهای نادرست اپلیکیشن را نشان میدهد. این چکها برای تشخیص مشکلات منطقی کسبوکار و مشکلات وابستگیهای داخلی مهم هستند.

پایش از نقاط جغرافیایی مختلف، دید وسیعتری از تجربه کاربران واقعی فراهم میکند. این مانیتورینگ جغرافیایی میتواند مشکلات شبکهای، اختلافهای CDN و تفاوتهای Latency بین مناطق را مشخص کند.

استفاده از چند نقطه مانیتورینگ در مناطق مختلف، میزان خطاها و نوسان تاخیر را نشان میدهد. این امر به شما کمک میکند تا برای توزیع ترافیک و بهینهسازی CDN تصمیمگیری بهتری بگیرید.

توصیه عملی این است که از ترکیب پینگ، HTTP health check و مانیتورینگ توزیعشده بهره ببرید. این ترکیب، پوشش کاملتری فراهم میسازد و احتمال false positive را کاهش میدهد.

monitor api endpoint uptime

برای تضمین دسترسی به سرویسهای خود، داشتن یک استراتژی روشن برای monitor api endpoint uptime ضروری است. این بخش به شما کمک میکند تا نقاط مانیتورینگ مناسب را انتخاب کنید، فاصلههای بررسی را تنظیم کنید و نتایج را بهدرستی تفسیر نمایید.

انتخاب نقاط مانیتورینگ باید بر اساس محل کاربران و ساختار شبکه انجام شود. در ایران، ترکیبی از نقاط on-prem و ابری بینالمللی توصیه میشود. این کار تجربه واقعی کاربران در تهران و سایر نقاط کشور را سنجیده و بهبود میبخشد.

برای تعیین نقاط مانیتورینگ، ابتدا نقاط کلیدی مشتریان، مراکز داده و نقاط لبه را فهرست کنید. سپس هر نقطه را از نظر دسترسی شبکه، مسیرهای CDN و وابستگیهای سرویس بررسی کنید.

بعد از آن، باید interval چک را تنظیم کنید. بازههای کوتاهتر مانند هر 30 ثانیه حساسیت را افزایش میدهند و مشکلات زودهنگام را آشکار میسازند. در مقابل، بازههای طولانیتر مانند 3 تا 5 دقیقه هزینه و تعداد هشدارهای کاذب را کاهش میدهند.

برای کاهش هزینه و حفظ دقت، یک مدل چندلایه پیشنهاد میشود. برای endpoints حیاتی از interval کوتاه استفاده کنید و برای مسیرهای کماهمیت، interval طولانیتر تنظیم کنید.

تریدآف بین حساسیت و هزینه را با سیاستهای چک متفاوت مدیریت کنید. برای critical endpoints، چکهای پرتکرار استفاده کنید و برای endpoints ثانویه، چکهای کمتر تنظیم نمایید.

نحوه تفسیر نتایج باید مبتنی بر تفکیک خطاهای گذرا و قطع واقعی باشد. از شروطی مانند سه خطای پیاپی قبل از اعلام incident استفاده کنید تا هشدارهای کاذب کاهش یابد.

برای محاسبه دقیق Uptime، پنجرههای زمانی نگهداری کنید و از متریکهای P95 و P99 برای تحلیل latency بهره ببرید. این متریکها ارتباط بین افزایش تاخیر و خطاهای اتصال را تشخیص میدهند.

در گزارشها، بازه و منبع چک را ذکر کنید تا بتوانید ریشه مشکل را سریعتر شناسایی کنید. درصد Uptime را با وزندهی به اهمیت هر endpoint محاسبه کنید تا تصویر واقعیتری از پایداری داشته باشید.

سرویسهایی مانند Uptimus as a Service و Balancer as a Service مگان میتوانند در توزیع چکها و افزایش پوشش جغرافیایی مفید باشند. این سرویسها کمک میکنند تا بتوانید بهراحتی نقاط را گسترده کنید و تنظیم interval چک را بر اساس نیاز عملیاتی تطبیق دهید.

طراحی سناریوهای چک سلامت (Health Check) برای API

برای تضمین پایداری سرویس، طراحی چندین سناریوی چک سلامت ضروری است. این سناریوها به بررسی وضعیت کلی، عملکرد مسیرهای حیاتی و وابستگیها کمک میکنند. این کار بهطور خودکار انجام میشود و باعث میشود هشدارها دقیقتر و واکنش تیم سریعتر شود.

سه نوع چک مهم وجود دارد که باید پاسخ JSON استاندارد داشته باشند. این پاسخها باید توسط سامانههای مانیتورینگ و ابزارهای دوآپس قابل خواندن و تفسیر باشند.

چک ساده وضعیت HTTP

ایجاد یک endpoint مانند /health یا /status اولین قدم در این مسیر است. این مسیر باید وضعیت کلی سرویس را گزارش دهد. پاسخ باید شامل فیلدهای status، version و uptime باشد.

نمونه اطلاعات شامل وضعیت سرویس، زمان اجرا و بررسی اتصالات شبکه است. این چک سریع و به عنوان اولین سیگنال عمل میکند.

چکهای عملکردی شامل فراخوانی مسیرهای مهم

برای بررسی عملکرد واقعی، مسیرهای کلیدی باید با درخواستهای واقعی تست شوند. این چک عملکردی باید عملیاتهایی مانند ورود، ایجاد رکورد و خواندن داده را شبیهسازی کند.

این سناریوها فشار اندکی به سرویس وارد میکنند و خطاهای منطقی یا مشکلات پایگاه داده را نشان میدهند. پاسخها باید زمان پاسخ و نتیجه عملیاتی را شامل جزئیات کنند.

چکهای وابستگیها مانند پایگاهداده یا سرویسهای خارجی

dependency health checks وضعیت منابع بیرونی را بررسی میکنند. پایگاهداده، کش، سرویس پیامرسان و درگاه پرداخت باید بهصورت جداگانه اعتبارسنجی شوند.

هر وابستگی باید در بخش components لیست و وضعیت اتصال و زمان پاسخ آن ثبت شود. در پیادهسازی میتوانید از سرویسهای Database as a Service مگان برای تست اتصال به دیتابیس استفاده کنید.

برای مصرفکنندگان مانیتورینگ، ساختار JSON شامل فیلدهای status، components و details پیشنهاد میشود. این قالب خواندن و همبستگی با لاگها را ساده میکند.

| نوع چک | هدف | خروجی پیشنهادی |

|---|---|---|

| چک ساده HTTP | تشخیص سریع در دسترس بودن سرویس | {“status”:”ok”,”version”:”1.2.3″,”uptime”:”72h”} |

| چک عملکردی | تأیید عملکرد مسیرهای کلیدی تحت بار سبک | {“route”:”/auth/login”,”result”:”success”,”latency_ms”:120} |

| چک وابستگیها | اعتبارسنجی اتصال به دیتابیس و سرویسهای ثالث | {“database”:”connected”,”redis”:”ok”,”payment_gateway”:”timeout”} |

برای بررسی وابستگیهای خارجی، از ابزارهای مانند N8N و سرویسهای پیامرسان مگان استفاده کنید. این روش بهخصوص در مواقعی که یک سرویس ثالث بحرانی است مفید خواهد بود.

در طراحی سناریوها از نرخ بررسی منطقی استفاده کنید تا بار غیرضروری روی سیستم وارد نشود. ترکیب Health Check API با dependency health checks و چک عملکردی باعث میشود سطح پوشش مانیتورینگ شما کامل و قابل اتکا باشد.

مانیتورینگ عملکرد و Latency همراه با Uptime

برای حفظ کیفیت سرویس، علاوه بر بررسی Uptime، باید روی latency monitoring سرمایهگذاری کنید. جمعآوری معیارهای تاخیر به شما کمک میکند تا رفتار سیستم را بهتر بفهمید و نقاط ضعف را زودتر شناسایی کنید.

اندازهگیری تاخیر و معیارهای مرتبط

اندازهگیری باید شامل میانگین، میانه، و درصدهای انتهایی باشد تا توزیع زمان پاسخ روشن شود. معیارهای P95 P99 latency نشان میدهند که کاربران کندترین تجربهها را چگونه میبینند. همچنین، زمان پردازش سرور و network RTT را ثبت کنید.

ردیابی روندهای افزایش Latency و ارتباط با Downtime

رصد طولانیمدت برای تشخیص افزایش تدریجی تاخیر ضروری است. افزایش پیوسته در P95 P99 latency معمولاً پیشنشانهای از بارگذاری بیش از حد یا مشکل زیرساختی است. آنالیز correlation latency downtime به شما امکان میدهد پیش از ایجاد قطع سرویس، واکنش اتوماتیک یا دستی را اجرا کنید.

نقشهبرداری نقاط بحرانی در زنجیره فراخوانی

ترِیسینگ توزیعشده با ابزارهایی مثل Jaeger یا Zipkin به شما امکان میدهد سرویسها و پایگاههای دادهای را که بیشترین تاخیر را ایجاد میکنند شناسایی کنید. ادغام Sentry as a Service برای خطا و ترِیسینگ، و Prometheus/Grafana برای متریکها، دید کاملی فراهم میآورد.

برای عملپذیری، آستانههای هشدار را بر مبنای P95 P99 latency تعریف کنید. کارهایی مانند اتوماسیون scale-up یا cache warming میتوانند پاسخ سریع به افزایش تاخیر باشند.

| هدف | متریک پیشنهادی | ابزار نمونه | اقدام خودکار |

|---|---|---|---|

| کشف تجربه کند کاربران | P95 P99 latency، میانه | Prometheus + Grafana | آستانه هشدار و scale-up سریع |

| تفکیک تاخیر شبکه و سرور | RTT، زمان پردازش سرور | Ping، ابزارهای APM | تغییر روتینگ یا افزایش منابع شبکه |

| شناسایی سرویسهای مشکلزا | Latency per span در ترِیس | Jaeger، Zipkin، Sentry as a Service | محدودسازی ترافیک یا fallback |

| تحلیل همبستگی با قطع سرویس | correlation latency downtime، روندها | Prometheus + Grafana + Tracing | ایجاد playbook و اجراي اتومات برای بازیابی |

اعلانها و Alerting مؤثر برای تیمهای فنی

برای مدیریت پایدار Uptime، طراحی یک سیستم اعلان هوشمند ضروری است. در این بخش، بر روی تعریف آستانهها، انتخاب کانالهای مناسب و روشهای کاهش هشدارهای کاذب تمرکز میکنیم. این کار به تیمهای زیرساخت و دوآپس کمک میکند تا سریع و دقیق واکنش نشان دهند.

آستانهها را بر اساس SLOها تعیین کنید. برای مثال، خطای بالای 1% یا P99 بالای 1s میتواند آستانه هشدار باشد. سطحبندی کنید: warning برای اختلالات قابل تحمل و critical برای مواردی که نیاز به مداخله فوری دارند. این روش اولویتبندی پاسخ را ساده میکند.

کانالهای اعلان برای واکنش سریع

از ترکیبی از ایمیل، Slack، Telegram و SMS برای اعلان استفاده کنید تا پیام به دست تیم برسد. ابزارهای دوآپس مانند PagerDuty یا Opsgenie به مدیریت شیفت و escalation کمک میکنند. در ایران میتوانید از Telegram API as a Service و Whatsapp API as a Service یا خدمات مگان برای اعلان داخلی بهره بگیرید.

کاهش هشدارهای کاذب و debounce

برای کاهش false positives از debounce و قاعده چند شکست متوالی استفاده کنید. شرط ترکیب چند منبع داده، مثل بررسی HTTP همراه با ترِیس، قبل از باز کردن incident، سطح اطمینان را بالا میبرد. این رویکرد باعث میشود تیم به هشدارهای واقعی تمرکز کند.

مدیریت تماسها و اجرای runbook

شیفتهای پاسخدهی و سیاست escalation را مشخص کنید تا تماسها به درستی منتقل شوند. هر سطح باید به یک runbook مرتبط باشد تا اقدامات اولیه مشخص و زمان پاسخ کاهش یابد. ادغام با Jenkins یا GitLab اجازه میدهد اسکریپتهای بازیابی خودکار اجرا شوند.

ابزارها و ادغامهای پیشنهادی

برای هماهنگی با روند عملیاتی، از Taska as a Service برای مدیریت وظایف پس از incident استفاده کنید. اتصال اعلانها به Jenkins as a Service یا GitLab as a Service فرآیندهای بازیابی را خودکار میسازد و وزن کاری تیم را کم میکند.

دستورالعملهای اجرایی سریع

پیششرطها را تعریف کنید: چه اطلاعاتی در اعلان باید باشد، چه متریکهایی همراه پیام ارسال شوند و چه نفراتی در شیفت واکنش نشان دهند. این ساختار به کاهش هشدارهای مانیتورینگ بیاثر کمک میکند و فرآیند پاسخگویی را قابل تکرار میسازد.

جمعآوری لاگ و ترِیسینگ برای تشخیص دلیل Downtime

برای تشخیص سریع علت Downtime، لازم است که لاگها و ترِیسها به صورت یکپارچه جمعآوری شوند. این کار به ما اجازه میدهد تا یک دید یکپارچه از عملکرد سیستم داشته باشیم و زمان لازم برای ریشهیابی را کاهش دهیم.

اولاً، باید روی پیادهسازی لاگینگ ساختاریافته تمرکز کنیم. ذخیره لاگها به صورت JSON با فیلدهای استاندارد مانند timestamp، request_id، service، level و message، جستجو و فیلترینگ را آسان میکند. این روش، بهترین پایه برای همپوشانی بین لاگها و ترِیسها است.

نکات پیادهسازی لاگینگ ساختاریافته

فیلد request_id را در لایه ورودی تولید کنید و آن را در هدرهای HTTP منتقل کنید. این کار هر لاگ را به یک درخواست مشخص متصل میکند. از سطحهای لاگ معنادار استفاده کنید تا حجم دادهها کاهش یابد و هشدارها دقیقتر شوند.

سیاست retention را مشخص کنید و دادههای حساس را رمزنگاری کنید. استفاده از Storage as a Service مگان برای نگهداری امن و مقیاسپذیر لاگها، سازگار با نیازهای بزرگ است.

استفاده از ترِیسینگ توزیعشده برای ردیابی درخواستها

ترِیسینگ توزیعشده به ما اجازه میدهد تا مسیر کامل یک درخواست را در سرویسهای مختلف دنبال کنیم. ابزارهایی مانند Jaeger، Zipkin و Sentry میتوانند ترِیسها را جمعآوری و نمایش دهند.

وقتی request_id در همه سرویسها حفظ شود، میتوانیم مجموعهای از اسپنها را به هم پیوند دهیم. این کار به ما کمک میکند تا نقاطی که افزایش Latency یا خطا رخ داده است را شناسایی کنیم. این فرآیند، شرط لازم برای همپوشانی بین لاگها و ترِیسها است.

همبستگی بین لاگ، متریک و ترِیس برای ریشهیابی سریع

برای رسیدن به مشاهدهای کامل، باید لاگها، متریکها و ترِیسها را همگام کنیم. به عنوان مثال، افزایش خطا و رشد Latency که با یک خطای دیتابیس همراه است، نشان دهنده علت ریشهای است.

در عمل، ابزارهای مانیتورینگ باید رویدادها را در یک داشبورد نمایش دهند تا بتوانیم الگوها را سریع تشخیص دهیم. ادغام Sentry as a Service با سیستم CI/CD مثل GitLab یا Jenkins باعث میشود گزارشها و اجرای تستهای بازتولید بعد از رخداد خودکار گردد. برای آشنایی بیشتر با سرویس Sentry، میتوانید به معرفی سرویس Sentry مراجعه کنید.

| جنبه | عملکرد | پیشنهاد پیادهسازی |

|---|---|---|

| structured logging | جستجوی سریع و فیلتر بر اساس فیلدها | ذخیره JSON با timestamp و request_id و سطح لاگ مناسب |

| distributed tracing | ردیابی مسیر کامل درخواست بین سرویسها | استفاده از Jaeger/Zipkin/Sentry و انتقال شناسه درخواست |

| correlating logs and traces | همبستگی بین رویدادها برای ریشهیابی | همگامسازی timestamps، استفاده از request_id و داشبورد مشترک |

| نگهداری و امنیت | حفاظت از داده و سیاست retention | رمزنگاری، تعیین retention و استفاده از Storage as a Service مگان |

| اتوماسیون پاسخ | اجرای تستهای بازتولید و گزارش خودکار | ادغام با GitLab/Jenkins و Sentry as a Service برای خودکارسازی |

خودکارسازی واکنش به کاهش Uptime و بازیابی سرویس

برای کاهش زمان بازیابی و حفظ تجربه کاربر، باید یک زنجیره اتوماسیون از شناسایی تا بازگردانی طراحی کنید. این زنجیره شامل تشخیص مشکل از طریق متریکها، اجرای اسکریپتهای از پیش تعریفشده و در صورت نیاز، انتقال ترافیک به نسخه پشتیبان است.

ابتدا سناریوهای شکست را فهرست کنید و برای هر کدام یک روال آشکار بنویسید. این روالها باید با ابزارهای مانیتورینگ و alerting شما هماهنگ باشند تا اجرای automated remediation تنها پس از تایید رخ دهد.

در ادامه سه بخش عملی را بررسی کنید که به شما در طراحی واکنش خودکار کمک میکنند.

اسکریپتها و اجرای خودکار Restart یا Failover

اسکریپتهایی بنویسید که در مواجهه با افزایش error rate یا کاهش پاسخدهی، سرویس را ریستارت کنند. این اسکریپتها میتوانند پاکسازی کش، بازنشانی کانکشن به دیتابیس یا اجرای jobهای CI/CD در Jenkins یا GitLab را راهاندازی کنند.

اگر مشکل تکرار شد، سیستم باید به صورت مرحلهای به failover automation منتقل شود تا ترافیک به نسخه پشتیبان هدایت شود و MTTR کاهش یابد.

استفاده از Runbooks و playbookهای دوآپس

برای هر سناریوی خطا یک runbook روشن و قابل اجرا تهیه کنید. این سندها گامبهگام عملیات بازیابی را توصیف میکنند و در قالب playbook قابل اجرا در ابزارهایی مانند Ansible یا Taska نگهداری میشوند.

ادغام این runbookها با سیستمهای اطلاعرسانی و چتاپها روند تصمیمگیری را سریعتر میکند و عملیات دستی را تا حد ممکن کاهش میدهد.

ادغام با ابزارهای Orchestration مانند Kubernetes

در خوشههای Kubernetes از liveness و readiness probes بهره ببرید تا Kubernetes health checks به صورت خودکار نودها یا پادهای ناسالم را تشخیص دهند. این چکها اجازه میدهند که kubelet یا controllerها پادها را ریستارت یا جایگزین کنند.

Auto-scaling و قابلیتهای rollout در Kubernetes به شما امکان میدهند که در شرایط افزایش بار یا خطا، مقیاسبندی و failover automation را بدون دخالت دستی انجام دهید. سرویسهایی مانند Kubernetes as a Service مگان میتوانند مدیریت این تنظیمات را ساده کنند.

| مرحله | عملیات خودکار | ابزار پیشنهادی | نکته فنی |

|---|---|---|---|

| تشخیص | شناسایی افزایش error rate یا افت پاسخ | Prometheus + Alertmanager | آستانهها با توجه به SLA تعیین شود |

| اولین واکنش | اجرای اسکریپت ریستارت یا پاکسازی cache | Jenkins as a Service, GitLab CI | لاک کردن اجرای همزمان برای جلوگیری از تداخل |

| گام بعدی | اجرای playbook برای بررسی و بازگردانی | Ansible, Taska as a Service | لاگگیری ساختاریافته برای ریشهیابی |

| Failover | هدایت ترافیک به نسخه پشتیبان | Envoy, Kubernetes Ingress, Service Mesh | قوانین مسیردهی و تست سلامت مداوم |

| پایش پس از بازیابی | بررسی مجدد سلامت و بازگشت ترافیک | Grafana, Uptimus | تایید پایدار بودن قبل از برگشت کامل |

یک سناریوی عملی ساده میتواند اینچنین باشد: وقتی error rate بیش از آستانه مشخص شد، ابتدا یک اسکریپت ریستارت رخ میدهد. اگر مشکل ظرف چند دقیقه حل نشد، automated remediation گام بعدی را فعال کرده و ترافیک را با قوانین failover automation به سرویس پشتیبان هدایت میکند.

در طراحی این فرایندها توجه کنید که Kubernetes health checks، سیاستهای rollout و سیگنالهای مانیتورینگ با هم همپوشانی داشته باشند تا از اجرای اشتباه اتوماسیون جلوگیری شود.

ابزارها و سرویسهای پیشنهادی برای مانیتورینگ Uptime

انتخاب ابزار مناسب برای مانیتورینگ Uptime نیازمند ارزیابی چندین عامل است. این عوامل شامل مقیاس، بودجه، نیازهای امنیتی و سطح اتوماسیون هستند. در ادامه، گزینههای متنباز و تجاری را بررسی کرده و مقایسهای بین آنها ارائه میدهیم تا انتخاب شما آگاهانهتر باشد.

ابزارهای متنباز برای تیمهایی که کنترل کامل را میخواهند، مناسب هستند. Prometheus با استفاده از Grafana، امکانات متریک و داشبورد را فراهم میکند. برای ترِیسینگ، Jaeger یا Zipkin مفید هستند. همچنین، ELK یا EFK stack برای مدیریت لاگها مناسب است.

این مجموعهها به دلیل هزینه نرمافزاری کمتری، مزایای زیادی دارند. اما، نگهداری، پیکربندی و مقیاسدهی به منابع فنی نیاز دارد که باید در تصمیمگیری به آن توجه شود.

ابزارهای تجاری تجربه کاربری سادهتری دارند و ادغامهای آمادهای دارند. Datadog و New Relic، متریک، لاگ و ترِیسینگ را یکجا ارائه میدهند. Pingdom و UptimeRobot برای مانیتورینگ ساده Uptime مناسب هستند. Sentry در تشخیص خطاها و گزارش استثناها قوی عمل میکند.

سرویسهای تجاری معمولاً پشتیبانی و SLA ارائه میدهند که مناسب سازمانهایی با نیاز به تضمین سرویس است. هزینه این سرویسها با رشد مقیاس افزایش مییابد، اما بار نگهداری روی تیم شما کاهش مییابد.

بحث Prometheus vs Datadog یک انتخاب رایج است. اگر به کنترل و هزینه قابل پیشبینی علاقهمندید، Prometheus گزینه مناسبی است. اگر به یک راهکار Managed با ادغامهای سریع نیاز دارید، Datadog انتخاب بهتری خواهد بود.

در هنگام انتخاب ابزار مانیتینگ، به چهار معیار اصلی توجه کنید: عمق بررسی و متریک، امکانات alerting، کیفیت داشبورد و میزان نگهداری مورد نیاز. هر ابزار در هر مورد وزن متفاوتی دارد و باید بر اساس اولویتهای شما ارزیابی شود.

اگر به دنبال کاهش پیچیدگی نگهداری هستید، میتوانید از سرویسهای Managed استفاده کنید. مگان خدماتی مانند Sentry as a Service، Uptimus as a Service و Infrastructure as a Service ارائه میدهد تا استقرار و مدیریت ابزارها ساده شود.

| ویژگی | Prometheus + Grafana | Datadog | New Relic | Pingdom / UptimeRobot |

|---|---|---|---|---|

| نوع | متنباز، خودمیزبان | تجاری، Managed | تجاری، Managed | تجاری، سرویس Uptime |

| متریک و داشبورد | قابلسفارشیسازی بالا با Grafana | داشبورد آماده و قابل سفارشیسازی | داشبورد جامع برای اپلیکیشن و زیرساخت | نمایش ساده وضعیت Uptime |

| ترِیسینگ | نیاز به ادغام با Jaeger/Zipkin | ترِیسینگ یکپارچه | ترِیسینگ و APM قدرتمند | محدود یا نیاز به ادغام |

| لاگینگ | ترکیب با ELK/EFK لازم است | لاگینگ یکپارچه یا ادغام آسان | لاگینگ و ارتباط با متریک | معمولاً لاگینگ ندارد |

| هشداردهی | قابلیتهای قوی اما نیاز به پیکربندی | قواعد آماده و هوشمند | قواعد هشدار و تحلیل علل | هشدار ساده برای قطعیها |

| هزینه نگهداری | بیشتر به دلیل خودمیزبانی | هزینه اشتراک متغیر با مقیاس | هزینه اشتراک و ماژولها | هزینه کم برای چکهای پایه |

| زمان استقرار | طولانیتر و فنی | سریعتر با ادغامها | سریع با ماژولهای آماده | بسیار سریع |

| پیشنهاد برای | تیمهای با مهارت داخلی و نیاز به کنترل | سازمانهای نیازمند راهکار Managed | تیمهای بزرگ با نیاز APM | پروژههای کوچک یا بررسی پایه |

برای انتخاب نهایی، فهرستی از نیازها بسازید و هر ابزار را براساس آن نمره دهید. مقیاسپذیری، هزینه کلی، نیاز به پشتیبانی و سازگاری با سیاستهای امنیتی سازمان را وزندهی کنید.

اگر زمان یا نیروی فنی محدود دارید، انتخاب سرویس Managed یا استفاده از خدمات مگان میتواند سریعترین مسیر به کارایی باشد. در غیر این صورت، یک استک متنباز انعطافپذیری بیشتری فراهم میکند و کنترل کامل در اختیار شما میگذارد.

نقش سرویسهای مگان در مانیتورینگ و پایداری APIها

وبلاگ مگان، مرجع آموزشی و راهنما برای پیادهسازی زیرساختهای ابری، کوبرنتیز و دیتاسنتر است. این وبلاگ شامل مطالب عملی در مورد مانیتورینگ، ابزارها و مطالعات موردی است که به پیادهسازی پایدار کمک میکند.

اگر به دنبال کاهش زمان قطع سرویس و افزایش کیفیت تجربه کاربر هستید، مگان خدمات زیرساخت، انتخاب مناسبی است. این خدمات شامل میزبانی، مدیریت Kubernetes و پشتیبانی از ابزارهای مانیتورینگ است که کار شما را ساده میکند.

در ادامه، فهرستی از راههایی که میتوانید از خدمات مگان برای مانیتورینگ استفاده کنید آورده شده است.

- استقرار سریع کلاسترهای Kubernetes همراه با probes و اتواسکیلینگ برای حفظ دسترسپذیری.

- حذف نیاز به مدیریت سخت و زمانبر سرورها با استفاده از Infrastructure as a Service.

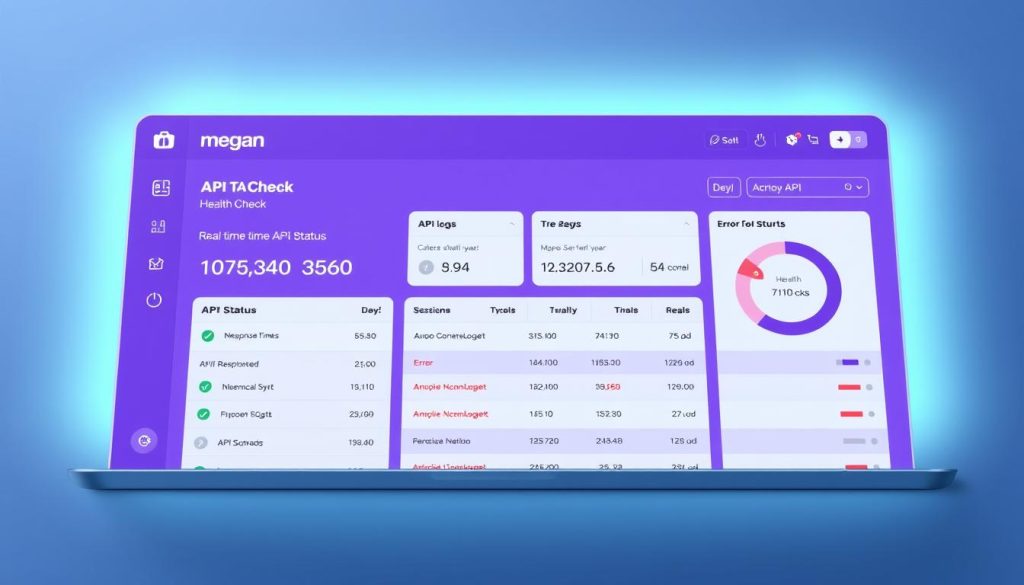

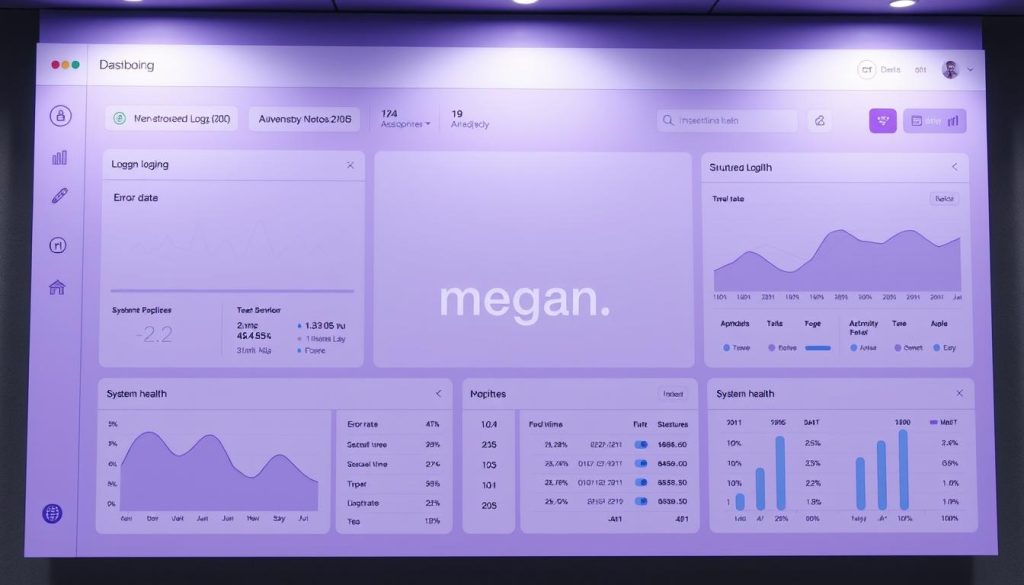

- راهاندازی سرویسهای پایش Uptime و تحلیل دسترسپذیری با Uptimus as a Service.

- یکپارچهسازی Sentry برای خطاپایش و ترِیسینگ درخواستها.

- روند نگهداری دادهها و لاگها در Database as a Service و Storage as a Service.

- تأمین امنیت و توزیع بار با Firewall as a Service و Balancer as a Service.

- اتوماسیون پاسخها با Jenkins/GitLab as a Service و Taska as a Service.

- استفاده از کانالهای اعلان مانند Telegram API و Whatsapp API as a Service برای هشدارها.

برای بسیاری از تیمها، Kubernetes as a Service مگان نقطه شروع امن و استانداردی است. این سرویس تنظیمات probe، readiness و liveness را به همراه سیاستهای autoscaling فراهم میکند تا سرویسهای API پایدار بمانند.

Uptimus as a Service برای سنجش مداوم Uptime طراحی شده است. شما میتوانید چکهای از نقاط جغرافیایی متنوع تعریف کنید و گزارشهای دقیق دریافت نمایید تا فاصله بین اختلال و تشخیص را کاهش دهید.

در جدول زیر، مقایسهای از امکانات کلیدی خدمات مگان آورده شده است تا انتخاب برای پیادهسازی مانیتورینگ آسانتر شود.

| خدمت | هدف اصلی | ویژگیهای کلیدی | مناسب برای |

|---|---|---|---|

| Kubernetes as a Service مگان | میزبانی و ارکستریشن کانتینرها | readiness/liveness probes، اتواسکیلینگ، مدیریت نود | اپلیکیشنهای میکروسرویسی و APIهای مقیاسپذیر |

| Uptimus as a Service | پایش دسترسپذیری و Uptime | چکهای توزیعشده، داشبورد SLA، اعلانهای بلادرنگ | سرویسهایی که نیاز به نظارت لحظهای دارند |

| Infrastructure as a Service (Insured) | میزبانی سرورها و شبکه | تنظیمات HA، شبکه اختصاصی، مانیتورینگ زیرساخت | سازمانهایی با نیاز به کنترل کامل زیرساخت |

| Sentry as a Service | ردیابی خطا و ترِیسینگ | جمعآوری استکترِیس، نوتیفیکیشن خطا، ارتباط با لاگ | تیمهای توسعه و اپراتورها برای ریشهیابی |

| Database / Storage as a Service | نگهداری امن دادهها و لاگها | نسخهگیری، encryption، دسترسی مقیاسپذیر | اپلیکیشنهایی با نیاز به پایداری داده |

| Firewall / Balancer as a Service | حفاظت و توزیع ترافیک | قواعد امنیتی، لودبالانس هوشمند، سلامتسنجی | سرویسهایی با نیاز به تحمل بار و امنیت بالا |

| Jenkins/GitLab / Taska as a Service | اتوماسیون و مدیریت وظایف | پایپلاین CI/CD، اجرای Runbook، task orchestration | فرآیندهای پاسخ خودکار و استقرار مستمر |

| Telegram / Whatsapp API as a Service | کانال اعلان | ارسال هشدار، گروهبندی اعلانها، API آماده | اعلان تیمی و هشدارهای فوری |

شما میتوانید این خدمات را از وبسایت مگان تهیه کنید و از مستندسازی و پشتیبانی آنها برای اجرای مانیتورینگ استفاده نمایید. با ترکیب Kubernetes as a Service مگان و Uptimus as a Service، عملیات مانیتورینگ شما هدفمند و قابل اتکا خواهد شد.

مطالعه موردی: پیادهسازی مانیتورینگ Uptime برای یک API واقعی

در این مطالعه عملی، روند کامل پیادهسازی مانیتورینگ برای یک سرویس پرداخت آنلاین را مشاهده میکنید. این سرویس شامل مسیرهای auth، transaction و status است و روی Kubernetes با پایگاهداده PostgreSQL اجرا میشود. هدف این است که گامهای فنی، ابزارها و نتایج قابل اندازهگیری برای بهبود قابلیت اطمینان را نشان دهد.

شرح سناریوی اولیه و معماری سرویس

شما یک API پرداخت دارید که درخواستهای احراز هویت و تراکنش را پردازش میکند. معماری این API شامل چندین پاد در Kubernetes، سرویس لودبالانسر و PostgreSQL بهعنوان دیتابیس مدیریتی است. رفتار ترافیک در ساعات اوج و وابستگی به دیتابیس، شاخصهای مهمی برای طراحی مانیتورینگ محسوب میشوند.

مراحل پیادهسازی چکها، اعلانها و خودکارسازی

ابتدا SLO تعریف میکنید: 99.95% Uptime برای endpointهای حیاتی. سپس نقطه انتهای /health و چکهای عملکردی برای مسیرهای auth و transaction اضافه میشود.

نقاط مانیتورینگ در چند منطقه توزیع میشوند تا پوشش جغرافیایی تامین شود. برای مسیرهای بحرانی interval برابر 30s و برای سایر مسیرها 5min تنظیم میشود.

برای جمعآوری متریک از Prometheus استفاده میکنید. داشبوردها در Grafana ساخته میشوند تا وضعیت Uptime و latency دیده شود. Jaeger برای ترِیسینگ توزیعشده و ELK برای لاگها پیادهسازی میگردد.

سیستم اعلان طوری پیکربندی میشود که هشدارها با debounce ارسال شوند و کانالهای Telegram و WhatsApp برای اطلاعرسانی تیم فعال شوند. در ادامه runbookها و اسکریپتهای اتوماتیک نوشته میشود تا در صورت نیاز restart pod یا failover دیتابیس اجرا گردد.

برای کاهش بار عملیاتی از Kubernetes as a Service و Database as a Service مگان بهره میبرید تا مدیریت خوشه و دیتابیس قابل اتکا باشد.

نتایج قابل اندازهگیری پس از اعمال تغییرات

بعد از اجرای این مجموعه اقدامات، MTTR شما از چند ساعت به کمتر از 15 دقیقه رسید. در روند تحلیل با ترِیسینگ، یک گلوگاه در سطح دیتابیس شناسایی شد که بعد از بهینهسازی باعث کاهش P99 latency از 2.4s به 450ms شد.

Uptime کل سرویس از 99.6% به 99.97% در بازه سه ماهه افزایش یافت. این مورد عملی نشان میدهد که ترکیب چکهای سطح اپلیکیشن، جمعآوری متریک و اتوماسیون میتواند کیفیت سرویس را بالا ببرد.

| هدف | پیش از پیادهسازی | پس از پیادهسازی |

|---|---|---|

| Uptime کلی | 99.6% | 99.97% |

| MTTR (میانگین زمان بازیابی) | چند ساعت | کمتر از 15 دقیقه |

| P99 Latency | 2.4s | 450ms |

| ابزارهای اصلی | محدود، بدون ترِیسینگ جامع | Prometheus, Grafana, Jaeger, ELK |

| نقاط مانیتورینگ | تک منطقه | چند منطقه با intervalهای 30s/5min |

| خودکارسازی واکنش | دستی | runbookها و اسکریپتهای restart/failover |

این نمونه عملی مانیتورینگ API نشان میدهد که برنامهریزی دقیق، انتخاب ابزار مناسب و پیکربندی هوشمندانه alerting میتواند تاثیر مستقیم بر قابلیت اطمینان سرویس داشته باشد. مطالعه موردی یادآور اهمیت مشاهدهپذیری کامل و اتوماسیون در حفظ سطح سرویس است.

بهینهسازی هزینه و مقیاسپذیری راهحلهای مانیتورینگ

برای مدیریت مانیتورینگ در سطح سازمان، باید بین پوشش کامل و کنترل هزینه تعادل برقرار کنید. رویکردهای عملی مانند گروهبندی endpointها بر اساس اولویت، تنظیم فواصل بررسی و انتخاب چکهای کمهزینه به شما کمک میکنند تا هزینهها کاهش یابند و کیفیت مانیتورینگ حفظ شود.

در مرحله بعد، باید سیاستهایی برای sampling و نگهداری دادهها پیاده کنید. با استفاده از sampling for metrics میتوانید متریکهای پرترافیک را نمونهبرداری کنید و تنها برای درصدهای حساس مانند P95 و P99 دادهٔ کامل نگه دارید. این کار حجم ذخیرهسازی و هزینههای پردازشی را به شدت کاهش میدهد.

برای مقیاسپذیری راهحل، توصیه میشود از سرویسهای Managed مانند Kubernetes as a Service استفاده کنید. پیادهسازی یک scalable monitoring architecture که از Auto Scaling پشتیبانی کند، مانع از بار اضافی روی ابزارهای داخلی میشود و پاسخگویی را در زمان رشد ترافیک حفظ میکند.

یک پیشنهاد عملی اعمال سیاستهای retention هوشمند و فشردهسازی لاگهاست. انتقال لاگهای قدیمی به Storage as a Service و نگهداری خلاصههای رویداد به جای لاگهای پرجزئیات، بخش اعظم هزینههای بلندمدت را کاهش میدهد.

برای تصمیمگیری مالی، KPIهایی تعریف کنید که هزینه را مقابل ریسک Downtime بسنجند. محاسبهٔ هزینه به ازای هر دقیقه عدمدسترسپذیری و تعیین آستانهٔ هزینهپذیری به شما اجازه میدهد بین افزایش نقاط مانیتورینگ یا افزایش بازه بررسیها انتخاب آگاهانهای داشته باشید.

در ادامه، یک جدول مقایسهای عملی برای گزینههای رایج ارائه شده است. با نگاه به این جدول میتوانید trade-off هزینه و کیفیت را سریعتر ارزیابی کنید.

| گزینه | نرخ هزینه | تأثیر بر دقت | نیاز به مقیاسپذیری | نکته عملی |

|---|---|---|---|---|

| بررسی کامل هر دقیقه | بالا | بسیار دقیق | نیاز به مقیاسپذیری قوی | برای endpointهای بحرانی مناسب است |

| نمونهبرداری متریکها (sampling for metrics) | متوسط | دقیق برای P95/P99 | نیاز کمتر نسبت به بررسی کامل | برای ترافیک بالا و متریکهای طولانیمدت توصیه میشود |

| چکهای سینتتیک کمهزینه | کم | مناسب برای درک کلی سلامت | قابل اجرا با معماری مقیاسپذیر | برای گروههای کماهمیت مناسب است |

| استفاده از سرویس Managed | متوسط تا بالا (اما پیشبینیپذیر) | خوب با پشتیبانی SLAs | بسیار مناسب برای رشد ناگهانی | کاهش نیروی نگهداری و خودکارسازی مقیاس |

| Retention هوشمند و انتقال لاگ | کم در بلندمدت | دقت حفظ میشود با خلاصهسازی | کمک به کاهش نیاز به ذخیرهسازی داخلی | ترکیب با فشردهسازی و Storage as a Service |

امنیت و حریم خصوصی در فرآیند مانیتورینگ

در هر راهکار مانیتورینگ، تعادل بین دیدپذیری و محافظت از دادهها ضروری است. شما باید معیارهای دسترسپذیری را بدون به خطر انداختن اطلاعات حساس گردآوری کنید. رعایت اصول monitoring security و توجه به log privacy از پایههای این کار هستند.

برای فراخوانی APIهای محافظتشده از حسابهای سرویس، از حسابهای با دسترسی کمتر استفاده کنید. رمزنگاری ارتباطات با TLS اجباری است و توکنها باید در ابزارهای امن مانند HashiCorp Vault یا Google Secret Manager نگهداری شوند. تعریف IP allowlist برای نقاط مانیتورینگ دسترسی را محدود میکند و secure health checks را قابل اعتمادتر میسازد.

لاگها باید پیش از ارسال به سیستم مرکزی پاکسازی یا ماسک شوند. فیلدهای حساس مانند شماره کارت، شناسههای شخصی و توکنها باید حذف شوند. سیاستهای retention را مشخص کرده و دسترسی به لاگها را با RBAC سخت بگیرید تا log privacy حفظ شود.

رمزنگاری در حالت transit و at-rest ضروری است. همه دسترسیها باید لاگ شوند تا امکان ممیزی وجود داشته باشد. این لاگهای دسترسی برای اثبات سازگاری با مقررات و بررسیهای امنیتی اهمیت دارند.

برای تطابق با قوانین محلی و سیاستهای سازمانی، فرایند auditing را تعریف کنید. گزارشهای منظم تهیه کرده و مکانیزمهایی برای بررسی تغییرات پیکربندی و دسترسیها داشته باشید تا پیروی از الزامات compliance قابل اثبات باشد.

خدمات مگان میتواند در محافظت از دادهها کمک کند. استفاده از Firewall as a Service و Storage as a Service برای نگهداری امن لاگها و اسرار، و استفاده از ابزارهای مدیریت کلید و دسترسی، تجربه شما را در secure health checks بهبود میدهد.

در طراحی راهکار، به نکات فنی مانند مدیریت امن توکن، اجرای least privilege، و الزام به لاگ کردن رخدادهای دسترسی پایبند باشید. این موارد تجربه مانیتورینگ را امن نگه میدارند و از نشت داده جلوگیری میکنند.

خلاصه

در این بخش، خلاصهای از مانیتورینگ Uptime ارائه میشود تا انتخاب و پیادهسازی آن سادهتر شود. برای مانیتورینگ API Endpointها، ترکیبی از چکهای شبکهای و اپلیکیشنی، پایش Latency، و جمعآوری لاگ و ترِیسینگ ضروری است. این کار به شما کمک میکند تا سرویس پایدار و قابل اطمینانی ارائه دهید.

در نتیجهگیری مانیتورینگ API، باید روی تعیین SLO و SLA، انتخاب نقاط مانیتورینگ مناسب و اجرای چکهای functional تمرکز کنید. اعلانها را با debounce تنظیم کنید و گردشکارهای خودکار برای واکنش سریع پیادهسازی کنید تا زمان بازیابی کاهش یابد.

خدمات مدیریتشده مانند Kubernetes as a Service، Uptimus as a Service و Database as a Service میتوانند پیچیدگیهای عملیاتی را کاهش دهند و سرعت پیادهسازی را افزایش دهند. برای گام بعدی، معماری فعلی را بررسی کنید، SLOها را تعیین کنید و یک PoC با ترکیبی از ابزارها و خدمات مگان اجرا کنید. این کار به شما کمک میکند تا نتایج را در کوتاهمدت اندازهگیری کنید.

FAQ

مانیتورینگ Uptime برای API Endpoint چیست و چرا برای شما مهم است؟

مانیتورینگ Uptime به معنای پیگیری مداوم از وضعیت در دسترس بودن و عملکرد صحیح API Endpointها است. این کار به شما کمک میکند تا سریعتر از مشکلاتی مانند قطع سرویس، افزایش زمان پاسخ و خطاهای HTTP آگاه شوید. کاهش Uptime میتواند به کاهش درآمد، اعتماد به نفس در بین مشتریان و نقض قراردادهای سرویس منجر شود.

چه شاخصهایی برای اندازهگیری وضعیت API باید دنبال کنید؟

برای اندازهگیری وضعیت API، باید از شاخصهای کلیدی مانند درصد Uptime، نرخ خطا (Error Rate 4xx/5xx)، میانگین زمان پاسخ (Avg Latency)، P95/P99 latency، تعداد رخدادهای قطع و MTTR استفاده کنید. این شاخصها نشاندهنده عملکرد و دسترسی به API هستند.

بهترین روش برای تعیین SLO و SLA چیست؟

برای تعیین SLO و SLA، ابتدا نیازهای تجاری و حساسیتهای Endpointها را دستهبندی کنید. بر اساس ریسک و ارزش تجاری، SLOهایی مانند 99.9% یا 99.95% تعیین کنید. سپس این اهداف را در SLA با مشتریان یا ذینفعان رسمی کنید. آستانههای هشدار و فرایندهای escalation بر اساس این اهداف پیادهسازی شود.

چه پیشنیازهای فنی قبل از راهاندازی مانیتورینگ لازم است؟

قبل از راهاندازی مانیتورینگ، باید از دسترسی شبکهای به نقاط مانیتورینگ به Endpointها، پیکربندی DNS و فایروال، مدیریت امن توکنها و حسابهای با حداقل دسترسی، و نصب ابزارهای پایه مانند Prometheus, Grafana, Jaeger یا ابزارهای SaaS مانند Datadog یا Sentry استفاده کنید.

پینگ ساده برای بررسی Uptime کافی است یا باید چیز دیگری هم چک کنم؟

پینگ ICMP سریع و سبک است اما عملکرد اپلیکیشن را نشان نمیدهد. برای بررسی دقیقتر، باید از چکهای سطح اپلیکیشن (HTTP(S) و بررسی کد وضعیت و محتوای پاسخ)، چکهای عملکردی و پایش از نقاط جغرافیایی مختلف استفاده کنید تا دید کاملی از وضعیت داشته باشید.

چگونه نقاط مانیتورینگ و بازههای بررسی را انتخاب کنم؟

نقاط مانیتورینگ را بر اساس توزیع کاربران و ریسک سرویس انتخاب کنید. برای endpoints حیاتی، بازههای کوتاهتر (مثلاً هر 30s) و برای مسیرهای کماهمیت، بازههای طولانیتر (مثلاً 5min) تعیین کنید. از چند نقطه پوشش جغرافیایی استفاده کنید تا مشکلات شبکهای منطقهای شناسایی شوند.

چه سناریوهایی برای Health Check باید پیادهسازی شوند؟

حداقلی یک endpoint /health یا /status با اطلاعات نسخه و وضعیت اتصال ضروری است. علاوه بر آن، چکهای عملکردی که مسیرهای حیاتی را فراخوانی میکنند و چکهای وابستگی برای دیتابیس، cache و سرویسهای خارجی را پیادهسازی کنید تا وضعیت کامل سرویس قابل ارزیابی باشد.

چگونه Latency را همراه با Uptime پایش کنم؟

برای پایش Latency، متریکهای میانگین، میانه، P95 و P99 را جمعآوری کنید و روندها را رصد کنید. از ترِیسینگ توزیعشده (Jaeger/Zipkin) برای یافتن گلوگاهها استفاده کنید و آستانههای هشدار مبتنی بر P95/P99 تعریف کنید تا پیش از Downtime واکنش نشان دهید.

بهترین روش اعلانها و کاهش هشدارهای کاذب چیست؟

آستانهها را بر اساس SLO تنظیم کنید و سطوح warning/critical داشته باشید. از debounce، شرط چند شکست متوالی و ترکیب منابع (HTTP + ترِیس) قبل از ایجاد incident استفاده کنید. کانالهای اعلان را شامل ایمیل، Slack/Telegram و ابزارهای PagerDuty/Opsgenie تنظیم کنید و سیاست escalation و شیفتبندی تعریف کنید.

چگونه لاگ و ترِیسینگ را برای تشخیص علت ریشهای Downtime سازماندهی کنم؟

لاگها را ساختاریافته (JSON) ذخیره کنید با فیلدهایی مثل timestamp, request_id و service. request_id را در تمام سرویسها عبور دهید تا ترِیسینگ توزیعشده ممکن شود. همبستگی بین لاگ، متریک و ترِیس را برقرار کنید تا علت ریشهای سریعتر کشف شود.

چه خودکارسازیهایی برای کاهش MTTR پیشنهاد میشود؟

اسکریپتهای restart، failover و پاکسازی cache را در CI/CD ادغام کنید. Runbookها و playbookهای دوآپس بنویسید و آنها را با اجرای خودکار در Jenkins یا GitLab مرتبط کنید. در Kubernetes از liveness/readiness probes و auto-scaling استفاده کنید تا واکنش اولیه خودکار باشد.

چه ابزارها و سرویسهایی برای مانیتورینگ Uptime مناسباند؟

ترکیبی از متنباز و تجاری معمولاً بهترین جواب را میدهد. Prometheus+Grafana، Jaeger/Zipkin و ELK برای کنترل کامل. Datadog، New Relic، Pingdom و Sentry برای پیادهسازی سریع و Managed. انتخاب بر اساس مقیاس، بودجه و نیاز به نگهداری انجام شود.

سرویسهای مگان چطور میتوانند به شما در مانیتورینگ کمک کنند؟

سرویسهای مگان مانند Kubernetes as a Service، Uptimus as a Service، Database as a Service و Sentry as a Service میتوانند میزبانی، مقیاس و ابزارهای مانیتورینگ را مدیریت کنند. این خدمات پیچیدگی عملیاتی را کاهش داده و پیادهسازی استاندارد و امن را تسهیل میکنند.

چگونه هزینههای مانیتورینگ را بهینه کنم بدون از دست دادن پوشش؟

endpointها را بر اساس اولویت گروهبندی کنید، بازه بررسیها را متناسب تنظیم کنید و از sampling برای متریکهای پرحجم استفاده کنید. نگهداری لاگها را هوشمندانه مدیریت و لاگهای قدیمی را به Storage as a Service منتقل کنید تا هزینهها کاهش یابد.

نکات امنیتی در مانیتورینگ API محافظتشده چیست؟

از حسابهای سرویس با حداقل دسترسی، رمزنگاری TLS، مدیریت امن اسرار با Vault یا Secret Manager و IP allowlist برای نقاط مانیتورینگ استفاده کنید. همچنین فیلدهای حساس در لاگ را ماسک کنید و سیاستهای retention و کنترل دسترسی را اعمال نمایید.

در یک مطالعه موردی واقعی چه نتایجی را میتوان انتظار داشت؟

با تعریف SLO روشن، پیادهسازی چکهای functional، پراکندگی نقاط مانیتورینگ، ترِیسینگ و اتوماسیون، معمولاً کاهش قابلتوجهی در MTTR، بهبود P99 latency و افزایش درصد Uptime قابل مشاهده است. مثال عملی شامل کاهش MTTR از چند ساعت به زیر 15 دقیقه و بهبود Uptime از 99.6% به 99.97% در سه ماه است.

چگونه نتایج مانیتورینگ را تفسیر کنم تا Uptime دقیق محاسبه شود؟

برای جلوگیری از اعلام اشتباه incident، از قوانین مثل سه خطای پیاپی قبل از ثبت قطع استفاده کنید. پنجرههای زمانی را برای محاسبه درصد Uptime نگه دارید و بین خطاهای گذرا و قطع واقعی تمایز قائل شوید. تحلیل P95/P99 برای تصمیمگیریهای عملکردی حیاتی است.

چه نکاتی برای مقیاسپذیری مانیتورینگ در رشد ترافیک باید در نظر داشته باشم؟

از سرویسهای Managed برای خودکارسازی مقیاس استفاده کنید، sampling و aggregation را برای متریکها بهکار گیرید و سیاستهای retention برای لاگها تعریف کنید. معماری مانیتورینگ باید افقی مقیاسپذیر باشد تا با افزایش ترافیک، هزینه و بار کنترل شود.

چگونه میتوانم با استفاده از ابزارهای موجود یک PoC مانیتورینگ پیادهسازی کنم؟

ابتدا SLOها را تعریف کنید، چکهای /health و چند چک functional ایجاد کنید، نقاط مانیتورینگ را از چند منطقه تنظیم کنید و Prometheus/Grafana یا یک سرویس SaaS را برای جمعآوری و نمایش متریک بهکار ببرید. سپس alerting پایه با debounce راهاندازی کنید و نتایج را در 2–4 هفته ارزیابی نمایید.